Gradient Based Learning Algorithm (1)

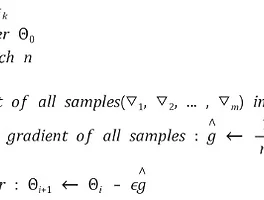

딥러닝에서 Learning Algorithm은 굉장히 중요한 요소입니다. Learning Algorithm은 Optimization(최적화) problem에 가장 큰 영향을 미치는 요소이기 때문에, 각 Learning Algorithm별 특징과 동작원리 장단점을 알아두어야 할 필요가 있는데요, Learning Algorithm에는 batch GD, SGD, Momentum SGD, AdaGrad, RMSprop, Adam 등이 있습니다. Ian Goodfellow의 Deep Learning, 오일석님의 Machine Learning과, 여러 논문, 기술 블로그들을 참고하여 Learning Algorithm들을 공부해보았고, 3번에 걸쳐 정리할 예정입니다. 혹시 잘못된 부분이 있다면 피드백 주시면 감사하겠..

Gradient Based Learning Algorithm (1)

딥러닝에서 Learning Algorithm은 굉장히 중요한 요소입니다. Learning Algorithm은 Optimization(최적화) problem에 가장 큰 영향을 미치는 요소이기 때문에, 각 Learning Algorithm별 특징과 동작원리 장단점을 알아두어야 할 필요가 있는데요, Learning Algorithm에는 batch GD, SGD, Momentum SGD, AdaGrad, RMSprop, Adam 등이 있습니다. Ian Goodfellow의 Deep Learning, 오일석님의 Machine Learning과, 여러 논문, 기술 블로그들을 참고하여 Learning Algorithm들을 공부해보았고, 3번에 걸쳐 정리할 예정입니다. 혹시 잘못된 부분이 있다면 피드백 주시면 감사하겠..